在CFX计算时经常会遇到内存不足的错误报告,有的算例网格并不多也会出现这样的问题,本文就最近遇到的内存错误问题以及解决方法进行简单的总结,以供大家参考。 1 CFX-Solver Manager内存种类 打开Define Run,面板...

”Partitioner的简单使用“ 的搜索结果

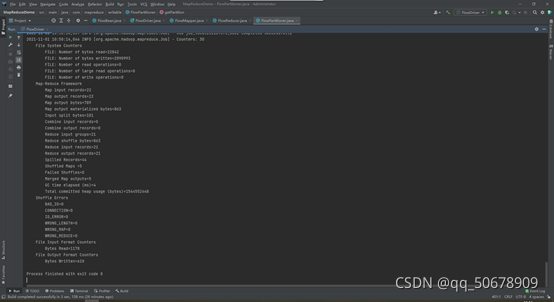

作者:禅与计算机程序设计艺术 1.简介 MapReduce简介 MapReduce是Google提出的一个并行计算模型和编程框架,旨在处理大数据量的海量计算任务。其全称“映射(mapping)”和“归约(reducing)”,即将大数据集分解为多...

本文主要分享 Flink connector 相关内容,分为以下三个部分的内容:第一...第二部分会重点介绍在生产环境中经常使用的 kafka connector 的基本的原理以及使用方法。第三部分答疑,对社区反馈的问题进行答疑。 Fl...

执行环境、数据源(source)、转换操作(transformation)、输出(sink)四大部分getExecutionEnvironment( )最简单的方式,就是直接调用 getExecutionEnvironment 方法。它会根据当前运行的上下文直接得到正确的...

Linux环境Spark安装配置及使用 1. 认识Spark (1) Spark介绍 大数据计算引擎 官网:spark.apache.org/ 官方介绍:Apache Spark™ is a unified analytics engine for large-scale data processing.(Apache Spark™...

大数据组件是解决大数据的关键组件之一,在Hadoop生态系统中占据着至关重要的地位,它包括了HDFS、MapReduce、Hive等等一系列框架和工具。本文将会通过主要分析HDFS、MapReduce、Hive三个大数据组件的特点和架构,并...

前言 在大量消息的情况下 Kakfa 是如何保证消息的高效...同时最好是有一定的 Kafka 使用经验,知晓基本的用法。 简单的消息发送 在分析之前先看一个简单的消息发送是怎么样的。(以下代码基于 SpringBoot 构建。) ...

Spark 分区策略

spark使用有kerberos认证的hbase是一个既麻烦又简单的问题,麻烦的方面是:中文的网站相关的文章很少并且分布只是分散的知识点。官网中给的信息也不够完整,倘若要是使用还是会出现自己采坑的想象。简单的方面是:...

Shuffle的本意是洗牌、混乱的意思,类似于java中的Collections.shuffle(List)方法,它会随机地打乱参数list里的元素顺序。MapReduce中的Shuffle过程。所谓Shuffle过程可以大致的理解成:怎样把map task的输出结果...

这是我的第64篇原创数据倾斜是上帝对某个服务器的过于偏爱。造成数据倾斜的原因上帝太过于偏爱某个服务器,因此给他分配了太多的任务,导致数据都倾斜到这台服务器了。在大数据场景中,无论是MapR...

Kafka之Producer生产者

标签: 后端

Producer就是负责向Kafka集群中写入消息数据的应用程序,自 Kafka 0.9 版本提供了Java版本的Producer SDK供用户使用, Kafka官方支持的语言SDK较少,更多都是由第三方社区维护的SDK,如果需要使用对应语言的SDK,...

简单使用 生产和消费的过程都是通过一个配置开始的. 生产者 //设置配置 config := sarama.NewConfig() //等待服务器所有副本都保存成功后的响应 config.Producer.RequiredAcks = sarama.WaitForAll //随机的...

在Apache Kafka简介的前半部分,您使用Kafka开发了几个小规模的生产者/消费者应用程序。从这些练习中,您应该熟悉Apache Kafka消息传递系统的基础知识。在下半部分,您将学习如何使用分区来分布负载并横向扩展应用...

2123 }24}注释上述代码展示了使用自定义接口的框架,实际实现需根据具体需求定制,以优化数据划分逻辑,提升并行效率。通过上述示例与详细注释,我们深入探索了PLINQ的核心特性,从基础的并行查询到进阶的并行度控制...

Flink(一)1.12.7或1.13.5详细介绍及本地安装部署、验证 Flink(二)1.13.5二种部署方式(Standalone、Standalone HA )、四种提交任务方式(前两种及session和per-job)验证详细步骤 Flink(三)flink重要概念(api...

当MapReduce中有多个reduce task执行的时候,此时map task的输出就会面临一个问题:究竟将自己的输出数据交给哪一个reducetask来处理?这就是数据分区(partition)默认情况下,MapReduce是只有一个reducetask来进行...

可连接两个都非常大的数据集之间可使用map端连接,数据在到达map端之前就执行连接操作。 需满足: 两个要连接的数据集都先划分成相同数量的分区,相同的key要保证在同一分区中(每个分区中两个数据集数据量...

1. MapReduce介绍 1.1 MapReduce的基本思想 ...MapReduce分为Map和Reduce两个阶段,Map负责“分”,即把复杂的任务分解为若干个“简单的任务”来并行处理,这些小任务可以并行计算,彼此间几乎没有依赖关...

hadoop

推荐文章

- GPT-ArcGIS数据处理、空间分析、可视化及多案例综合应用

- 在Debian 10上安装MySQL_debian mysql安装-程序员宅基地

- edge 此项内容已下载并添加到 Chrome 中。_一个小扩展,解决Chrome长期以来的大痛点...-程序员宅基地

- vue js 点击按钮为当前获得焦点的输入框输入值_vue获得当前获得焦点的元素-程序员宅基地

- Android 资源文件中@、@android:type、@*、?、@+含义和区别_@android @*android-程序员宅基地

- python中的正则表达式是干嘛的_Python中正则表达式介绍-程序员宅基地

- GeoGeo多线程_geo 多线程-程序员宅基地

- phpstudy的Apache无法启动_phpstudy apache无-程序员宅基地

- 数据泵导出出现ORA-31617错误-程序员宅基地

- java基础巩固-宇宙第一AiYWM:为了维持生计,两年多实验室项目经验之分层总结和其他后端开发好的习惯~整起_java两年经验项目-程序员宅基地