”bert“ 的搜索结果

BERT

标签: JupyterNotebook

BERT

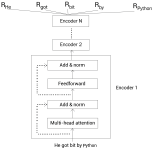

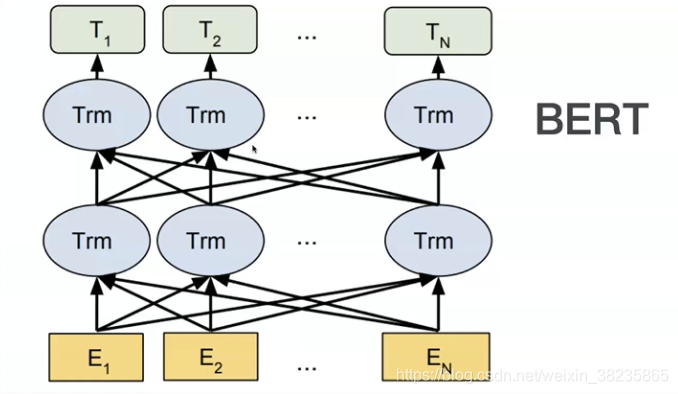

BERT(Bidirectional Encoder Representations from Transformers)是一种预训练模型,它是自然语言处理(NLP)领域的重大里程碑,被认为是当前的State-of-the-Art模型之一。BERT的设计理念和结构基于Transformer...

所谓预训练模型,举个例子,假设我们有大量的维基百科数据,那么我们可以用这部分巨大的数据来训练一个泛化能力很强的模型,当我们需要在特定场景使用时,例如做医学命名实体识别,那么,只需要简单的修改一些输出层...

bert文本分类 代码+数据bert文本分类 代码+数据bert文本分类 代码+数据

bert浅析

本课件是对论文 BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding 的导读与NLP领域经典预训练模型 Bert 的详解,通过介绍NLP领域对通用语言模型的需求,引入 Bert 模型,并对其...

在pytorch上实现了bert模型,并且实现了预训练参数加载功能,可以加载huggingface上的预训练模型参数。 主要包含以下内容: 1) 实现BertEmbeddings、Transformer、BerPooler等Bert模型所需子模块代码。 2) 在子模块...

1、内容概要:本资源主要基于bert(keras)实现文本分类,适用于初学者学习文本分类使用。 2、数据集为电商真实商品评论数据,主要包括训练集data_train,测试集data_test ,经过预处理的训练集clean_data_train和...

Fast-Bert是一个深度学习库,允许开发人员和数据科学家针对基于文本分类的自然语言处理任务训练和部署基于BERT和XLNet的模型。 FastBert的工作建立在优秀的提供的坚实基础上,并受到启发,并致力于为广大的机器...

BERT-pytorch

标签: Python

伯特·比托奇 Google AI的2018 BERT的Pytorch实现,带有简单注释BERT 2018 BERT:用于语言理解的深度双向变压器的预培训论文URL: : 介绍Google AI的BERT论文显示了在各种NLP任务(新的17个NLP任务SOTA)上的惊人...

BERT的对抗性嵌入 上基于BERT的情感分类对抗嵌入生成与分析。 建立在对Google Research之上。 IMDB加载器和处理器功能取自。 存储库还包括一种算法,用于投影对抗性嵌入内容以获得对抗性离散文本候选对象。 尽管该...

使用说明保存预训练模型在数据文件夹下├──数据│├──bert_config.json │├──config.json │├──pytorch_model.bin │└──vocab.txt ├──bert_corrector.py ├──config.py ├──logger.py ├──...

Bert

https://huggingface.co/google-bert/bert-base-chinese pytorch和tensorflow都有

我们已经证明,除了BERT-Base和BERT-Large之外,标准BERT配方(包括模型体系结构和训练目标)对多种模型尺寸均有效。 较小的BERT模型适用于计算资源有限的环境。 可以按照与原始BERT模型相同的方式对它们进行微调。...

AI音频克隆&TTS训练推理工具V1.4,Bert-VITS2支持整部小说转换成音频,不用搭建环境,解压即用! 音频克隆、文字转音频训练推理工具V1.4下载: bert功能与视频界面操作有所出入,请自行探索使用。 仅支持win10、win...

https://huggingface.co/google-bert/bert-base-uncased pytorch和tensorflow都有

scikit-learn包装器对BERT进行微调 一个scikit-learning包装器,可基于端口模型,以执行文本和令牌序列任务。 包括可配置的MLP作为文本和文本对任务的最终分类器/回归器 包括用于NER,PoS和分块任务的令牌序列分类...

Google BERT入门 这是Packt发布的《 的代码库。 使用BERT构建和训练最先进的自然语言处理模型 这本书是关于什么的? BERT(来自变压器的双向编码器表示形式)以令人鼓舞的结果彻底改变了自然语言处理(NLP)的...

使用Bert的中文NER BERT代表中文NER。数据集列表cner:数据集/ cner 主持人: : 型号清单BERT + Softmax BERT + CRF BERT +跨度需求1.1.0 = <PyTorch <1.5.0 cuda = 9.0 python3.6 +输入格式输入格式(首选...

pip install bert-extractive-summarizer 使用Neurocoref的共指功能需要一个spaCy模型,该模型必须单独下载。 默认模型是小型英语spaCy模型(en_core_web_sm,11Mb),并随此软件包自动安装。 要使用其他型号,您...

BERT和知识提炼的问题解答该存储库包含必要的代码,以便微调SQuAD 2.0数据集上的BERT。 此外,的技术是通过微调施加使用BERT作为教师模型小队2.0数据集。 使用Google Colab的1个Tesla V100 GPU获得了所有结果。1....

安装pip install bert-multitask-learning它是什么这个项目使用变压器(基于拥抱面部变压器)进行多模式多任务学习。我为什么需要这个在原始的BERT代码中,多任务学习或多GPU训练都不可行。 另外,该项目的初衷是NER...

使用BERT的细粒度情感分类 此存储库包含用于获取的结果的代码。 用法 可以使用run.py运行各种配置的实验。 首先,安装python软件包(最好在一个干净的virtualenv中): pip install -r requirements.txt Usage: ...

使用google BERT进行CoNLL-2003 NER! 使用Python训练模型并使用C ++进行推理 要求 python3 pip3 install -r requirements.txt 跑步 python run_ner.py --data_dir=data/ --bert_model=bert-base-cased --task_...

推荐文章

- cocos creator 实现截屏截图切割转成 base64分享--facebook小游戏截图base64分享,微信小游戏截图分享【白玉无冰】每天进步一点点_cocos上传base64-程序员宅基地

- Docker_error running 'docker: compose deployment': server-程序员宅基地

- ChannelSftp下载目录下所有或指定文件、ChannelSftp获取某目录下所有文件名称、InputStream转File_channelsftp.lsentry获取文件全路径-程序员宅基地

- Hbase ERROR: Can‘t get master address from ZooKeeper; znode data == null 解决方案_error: can't get master address from zookeeper; zn-程序员宅基地

- KMP的最小循环节_kmp求最小循环节-程序员宅基地

- 详解ROI-Pooling与ROI-Align_roi pooling和roi align-程序员宅基地

- Imx6ull开发板Linux常用查看系统信息指令_armv7 processor rev 2 (v7l)-程序员宅基地

- java SSH面试资料-程序员宅基地

- ant design vue table 高度自适应_对比1万2千个Vue.js开源项目发现最实用的 TOP45!火速拿来用!...-程序员宅基地

- 程序员需要知道的缩写和专业名词-程序员宅基地