docker使用宿主机的gpu设备,本质是把宿主机使用gpu时调用的设备文件全部挂载到docker上。nvidia提供了三种方式的演变,如下是官网的一些介绍 来自 <Enabling GPUs in the Container Runtime Ecosystem | ..

”gpu“ 的搜索结果

1

tensorflow查看GPU的数量、使用GPU加速,单GPU模拟多GPU环境等

1 pytorch使用多个GPU同时训练 在pytorch上使用多个GPU(在同一台设备上,并非分布式)进行训练是件非常容易的事情,只要在源代码中添加(修改)两行代码即可。 把模型放在GPU上: device = torch.device("cuda:0...

说明:第一次接触GPU服务器,从GUP的环境配置到连接pycharm,最后跑通代码。这其中必然踩了坑,饶了路。希望此博客能让跟我一样的小白,少踩雷,少绕路。

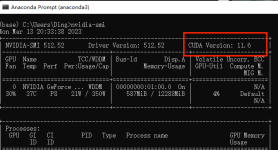

1. 查看gpu的使用详情: (1)查看gpu使用情况 nvidia-smi.exe # windows上 nvidia-smi -l #linux服务器上 # 显示的结果中 Volatile GPU-Util:浮动的GPU利用率; (2)linux上查看进程占用gpu的情况: ##实用...

查看GPU的使用情况及输出详解 1. 查看GPU的使用情况 1.1nvidia-smi 1.2nvidia-smi -l 1.3watch -n 1 nvidia-smi 2. 输出详解 2.1 标题部分 2.2 GPU 信息部分 2.3 性能和功耗部分 2.4 内存和利用率部分 2.5 进程部分

GPU和CPU计算速度

目前TensorFlow的最新版本(2.7)已经默认支持CPU和GPU。 安装前需要先确认显卡算力是否达到最新版的要求,算力低于3.0的版本本文暂不涉及。 自己亲测的组合有以下两种:(1)旧版(3.0 <算力 < 3.5):python...

GPU性能

前提:安装好Python3.6+,torch(GPU),登录一台开发机,。 1.查看cuda是否可用:torch.cuda.is_available()

本篇题目:GPU 调度 题目 为了充分发挥 GPU 算力, 需要尽可能多的将任务交给 GPU 执行, 现在有一个任务数组, 数组元素表示在这1s内新增的任务个数, 且每秒都有新增任务, 假设 GPU 最多一次执行n个任务, 一次...

超详细新手白嫖kaggle GPU教程,不可错过哦

使用本教程前,默认您已经安装并配置好了python3以上版本。

我们使用 Cudafy 属性来标记这个函数,使其可以被 CUDAfy.NET 库转换为 CUDA 代码,并在 GPU 上执行。需要注意的是,使用 GPU 进行计算需要考虑数据传输的开销。在进行 GPU 计算时,数据需要从主机内存复制到 GPU ...

推荐文章

- Python Django 版本对应表以及Mysql对应版本_django版本和mysql对应关系-程序员宅基地

- Maven的pom.xml文件结构之基本配置packaging和多模块聚合结构_pom <packaging>-程序员宅基地

- Composer 原理(二) -- 小丑_composer repositories-程序员宅基地

- W5500+F4官网TCPClient代码出现IP读取有问题,乱码问题_w5500 ping 网络助手 乱码 send(sock_tcps,tcp_server_buff,-程序员宅基地

- Python 攻克移动开发失败!_beeware-程序员宅基地

- Swift4.0_Timer 的基本使用_swift timer 暂停-程序员宅基地

- 元素三大等待-程序员宅基地

- Java软件工程师职位分析_java岗位分析-程序员宅基地

- Java:Unreachable code的解决方法_java unreachable code-程序员宅基地

- 标签data-*自定义属性值和根据data属性值查找对应标签_如何根据data-*属性获取对应的标签对象-程序员宅基地