from torch.nn.utils.rnn import pack_padded_sequence, pad_packed_sequence class TextDataset(Dataset): def __init__(self, data, labels, vocab): self.data = data self.labels = labels self.vocab = ...

”pad_packed_sequence“ 的搜索结果

一 Padding 文本数据在处理的时候,由于各样本的长度并不一样,有的句子长有的句子短。抛开动态图、静态图模型的差异,由于需要进行矩阵运算,句长需要是等长的才可以,这就需要padding操作。...

之前学过一段时间NLP,因为其中涉及到一些深度学习常用的知识或者框架,但苦于不系统以及没有任务focus不能长久.这里借助微软的教程写点东西.

由于输入文本长度不同,我们需要使用 `pack_padded_sequence` 和 `pad_packed_sequence` 函数对输入进行处理。最后,我们将 LSTM 层的输出通过全连接层得到最终的预测结果。 接下来,我们需要定义损失函数和优化器...

from torch.nn.utils.rnn import pack_padded_sequence, pad_packed_sequence class BiSRU(nn.Module): def __init__(self, input_size, hidden_size, num_layers, dropout): super(BiSRU, self).__init__() ...

本文以Pytorch为框架,实现了7种经典的深度学习中文文本分类模型,包括TextCNN、TextRNN、FastText、TextRCNN、TextRNN_Attention、DPCNN和Transformer。通过这篇文章,读者可以了解到各种深度学习中文文本分类模型...

第七节Seq2Seq, Attention import os import sys import math from collections import Counter import numpy as np import random import torch import torch.nn as nn import torch.nn.functional as F ...

output, _ = nn.utils.rnn.pad_packed_sequence(packed_output) return hidden, cell class AttentionDecoder(nn.Module): def __init__(self, vocab_size, emb_size, hidden_size, num_layers, dropout): ...

手把手构建Seq2Seq模型!!!

output, output_lengths = nn.utils.rnn.pad_packed_sequence(packed_output) hidden = self.dropout(torch.cat((hidden[-2,:,:], hidden[-1,:,:]), dim = 1)) return self.fc(hidden) # 初始化模型、优化器...

目录Seq2Seq,机器翻译Encoder-Decoder机器翻译数据集与数据预处理Encoder-Decoder模型损失函数训练与测试结合Luong Attention Seq2Seq,机器翻译Encoder-Decoder Seq2Seq是NLP的一个热门分支,模型通常应用于机器...

pack_padded_sequence和pad_packed_sequence来处理变长序列 collate_fn Dataloader的collate_fn参数,定义数据处理和合并成batch的方式。 由于pack_padded_sequence用到的tensor必须按照长度从大到小排过序的,...

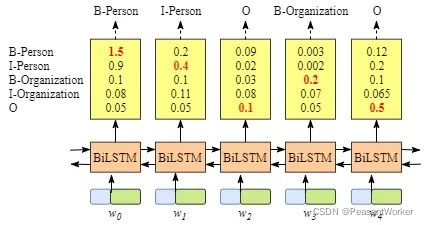

注意,本文代码来自于plm-nlp-code。 学习任何模型都需要一个简单可行的例子进行说明,我会基于plm-nlp-code的代码进行说明lstm在序列标注和句子极性二分类两个例子的应用。 序列标注参考文件lstm_postag.py. ...

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。 ...一 Padding 文本数据在处理的时候,由于各样本的长度并不一样,有的句子长有的句子短。抛开动态图、静态图模型的...

摘要:情感情绪检测是自然语言理解的关键要素。最近,我们将原来的项目迁移到了新的集成系统上,该系统基于麻省理工学院媒体实验室推出的NLP模型搭建而成。 情感情绪检测是自然语言理解的关键要素。...

7. 使用PyTorch的优化器优化显存使用:PyTorch提供了一些优化器,如`torch.optim`中的`pack_padded_sequence`和`pad_packed_sequence`,可以优化处理变长序列时的显存使用。 8. 使用PyTorch的分布式数据并行...

视频地址:...Sqe2Seq, Attention 先去 ...下载数据集(nmt文件夹) import os import sys import math from collections import Counter import numpy as np import random ...imp

1. 写在前面 今天开始,兼顾Pytorch学习, 如果刚刚接触深度学习并且想快速搭建神经网络完成任务享受快感,当然是Keras框架首选,但是如果想在深度学习或人工智能这条路上走的更远,只有Keras就显得有点独木难支,这...

注意:这里的batch指的是mini-batch 两种实现序列(文本、日志)批处理的方法 固定长度的batches(uniform length batches) 所有batch内序列的长度一样。比如seqs = [[1,2,3,3,4,5,6,7], [1,2,3], [2,4,1,2,3], [1...

介绍前文介绍了许多方法来获取静态词向量,本文介绍使用lstm来训练词向量。 模型12345678910111213141516171819class RNNLM(nn.Module): def __init__(self, vocab_size, embedding_dim, hidden_dim): super(RNNLM, ...

推荐文章

- Ubuntu/linux下下载工具_ubuntu下载软件助手 linux版本-程序员宅基地

- HTML、JSP前端页面国际化(i18n)_html全局国际化-程序员宅基地

- Python高级-08-正则表达式_写出能够匹配只有下划线和数字还有字母组成(且第一个字符必须为字母)的163邮箱(@1-程序员宅基地

- 寻仙手游维护公告服务器停服更新,寻仙手游2月1日停服更新公告 2月1日更新了什么...-程序员宅基地

- 用python自动预约图书馆座位_微信图书馆座位秒抢脚本-程序员宅基地

- Android真机或模拟器激活Xposed框架的方法_de.robv.android.xposed.installer-程序员宅基地

- 操作系统为什么要分用户态和内核态_用户态和内核态都需要cpu参与,为什么要区分-程序员宅基地

- 01—JVM与Java体系结构(简单介绍)_01_jvm与java体系结构.pptx-程序员宅基地

- 国有建筑企业数字化转型整体解决方案_建筑企业数字化转型行动方案-程序员宅基地

- 性能测试的软件------loadrunner_loadrunner有有三个图标,-程序员宅基地