`UserDefinedAggregateFunction` 是 Spark SQL 中用于实现用户自定义聚合函数(UDAF)的抽象类。通过继承该类并实现其中的方法,可以创建自定义的聚合函数,并在 Spark SQL 中使用。

”spark2原理分析“ 的搜索结果

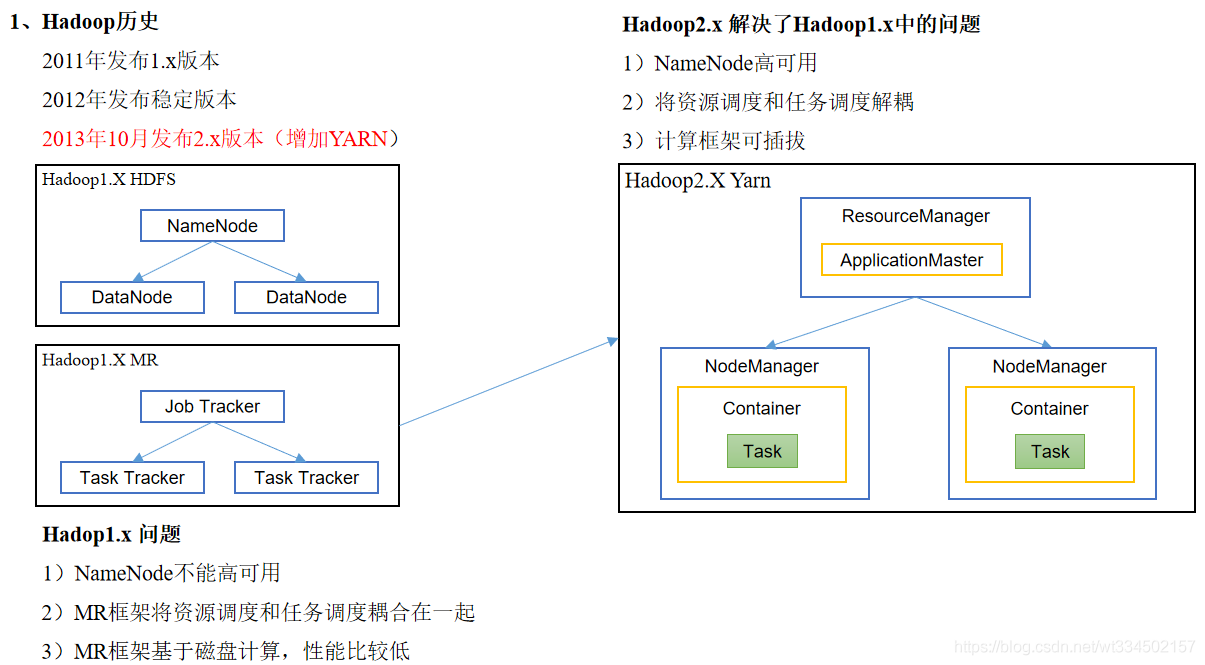

Spark Standalone集群是主从架构的集群模式,由于存在单点故障问题,解决这个问题需要用到Zookeeper服务,其基本原理是将Standalone集群连接到同一个Zookeeper实例并启动多个Master节点,利用Zookeeper提供的选举和...

在体验第一个Spark程序之前,确保已经安装好了Spark,并且配置环境变量和启动Spark集群。接着,创建一个新的Spark应用程序,命名为SparkPi,...通过命令行参数获取切片的数量(默认为2),计算需要生成的随机点的总数。

不过,本书绝不仅仅限于Spark的用法,它对Spark的核心概念和基本原理也有较为全面的介绍,让读者能够知其然且知其所以然。 本书介绍了开源集群计算系统Apache Spark,它可以加速数据分析的实现和运行。利用Spark,...

, 《深入理解SPARK:核心思想与源码分析》一书对Spark1.2.0版本的源代码进行了全面而深入的分析,旨在为Spark的优化、定制和扩展提供原理性的指导。阿里巴巴集团专家鼎力推荐 、阿里巴巴资深Java开发和大数据专家...

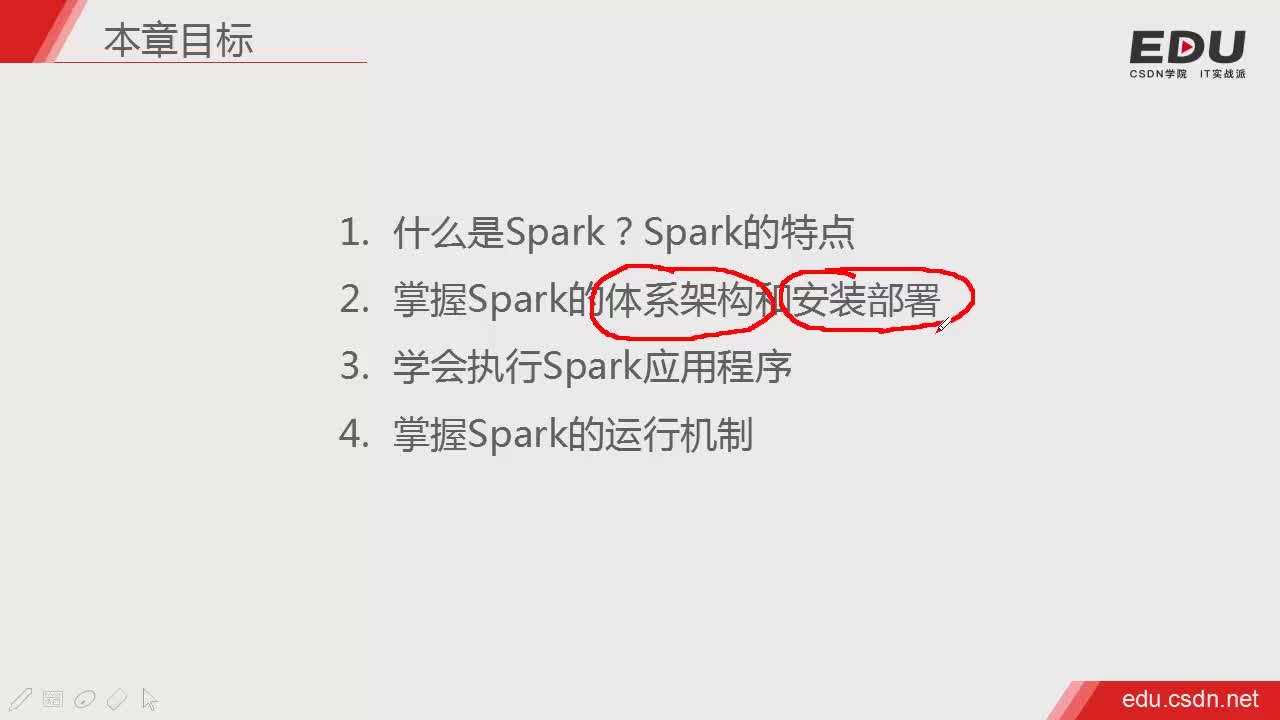

参考文章:Spark 以及 spark streaming 核心原理及实践 导语 spark 已经成为广告、报表以及推荐系统等大数据计算场景中首选...2. Spark 特点 运行速度快 => Spark拥有DAG执行引擎,支持在内存中对数据进行迭代

一、union算子内部实现原理剖析 说明:将两个RDD合并,返回两个RDD的并集,返回元素不去重。 二、groupByKey算子内部实现原理剖析 说明:将RDD[K, V]中每个K对应的V值合并到一个集合Iterable[V]中。 三...

Apache Spark是一个围绕速度、易用性和复杂分析构建的大数据处理框架,最初在2009年由加州大学伯克利分校的AMPLab开发,并于2010年成为Apache的开源项目之一,与Hadoop和Storm等其他大数据和MapReduce技术相比,...

ContextCleaner是SparkContext中的组件之一。ContextCleaner用于清理那些超出应用范围的RDD、Shuffle对应的map任务状态、Shuffle元数据、Broadcast对象以及RDD的Checkpoint数据。 创建ContextCleaner ...

Spark快速数据分析-高清

标签: Spark

不过,本书绝不仅仅限于Spark的用法,它对Spark的核心概念和基本原理也有较为全面的介绍,让读者能够知其然且知其所以然。 本书介绍了开源集群计算系统Apache Spark,它可以加速数据分析的实现和运行。利用Spark,...

本文介绍Dataset的UDF的实现原理。UDF是User-Defined Functions的简写。用户可以根据自己的需要编写函数,并用于Spark SQL中。但也要注意,Spark不会优化UDF中的代码,若大量使用UDF可能让数据处理的性能受到影响,...

通过学习Spark,我掌握了分布式数据处理的基本原理和技巧,并通过实践应用到了大规模数据集的处理中。通过学习Spring Boot,我了解了现代化的Java Web开发方式,并通过实践构建了一些简单的Web应用程序。我还意识到...

通过学习Spark,我掌握了分布式数据处理的基本原理和技巧,并通过实践应用到了大规模数据集的处理中。通过学习Spring Boot,我了解了现代化的Java Web开发方式,并通过实践构建了一些简单的Web应用程序。我还意识到...

Spark的Worker在启动之后,就会主动向Master进行注册。Master会对Worker进行过滤,将状态为DEAD的Worker过滤掉;对于状态为UNKNOWN的Worker,清理掉旧的Worker信息,替换为新的Worker信息。然后Master会把完成过滤...

通过学习Spark,我掌握了分布式数据处理的基本原理和技巧,并通过实践应用到了大规模数据集的处理中。通过学习Spring Boot,我了解了现代化的Java Web开发方式,并通过实践构建了一些简单的Web应用程序。我还意识到...

通过学习Spark,我掌握了分布式数据处理的基本原理和技巧,并通过实践应用到了大规模数据集的处理中。通过学习Spring Boot,我了解了现代化的Java Web开发方式,并通过实践构建了一些简单的Web应用程序。我还意识到...

https://towardsdatascience.com/apache-hive-optimization-techniques-2-e60b6200eeca

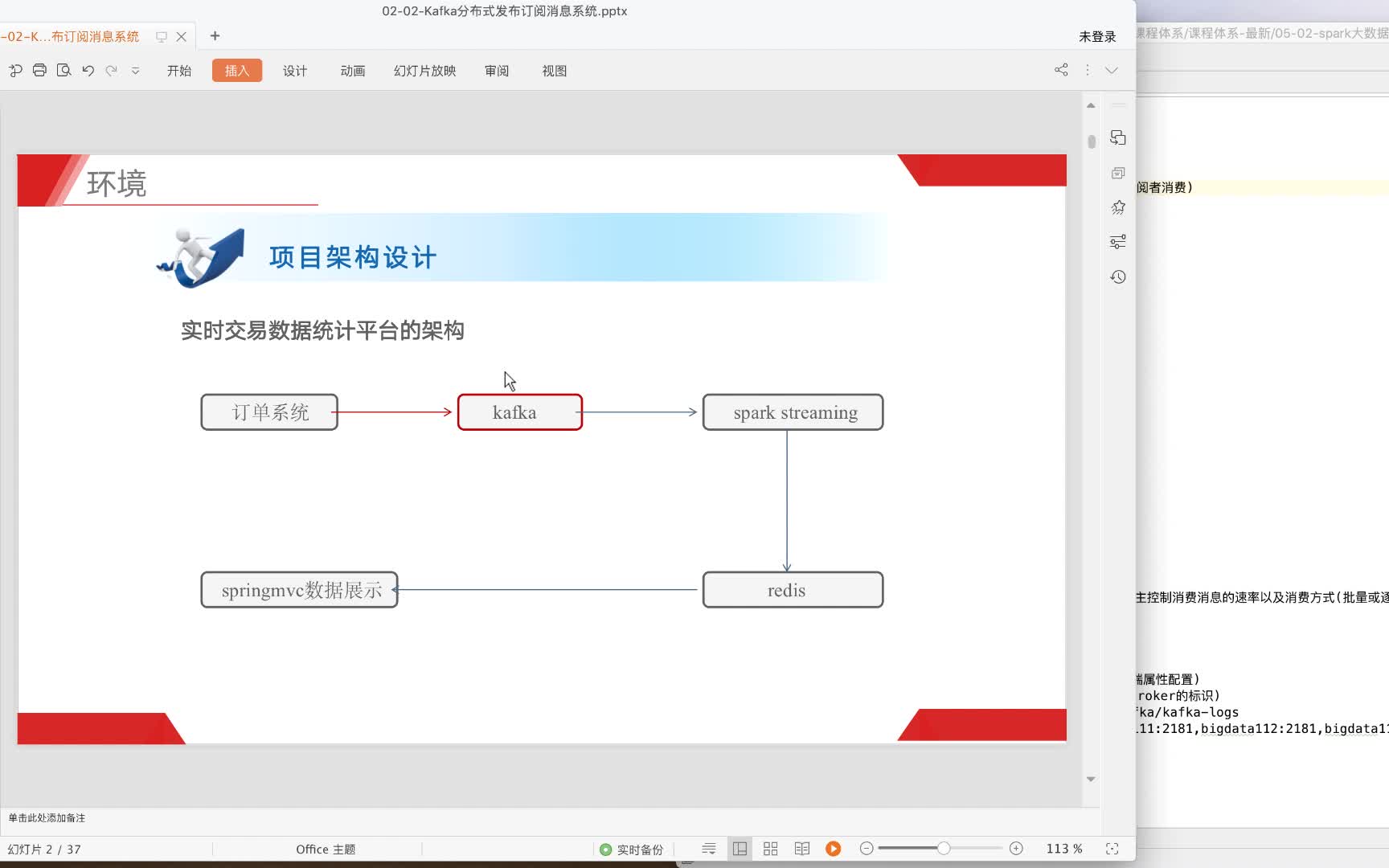

5.SparkStreaming工作原理 6.DStream及函数 7.集成Kafka 8.案例:百度搜索风云榜(实时ELT、窗口Window和状态State) 9.SparkStreaming Checkpoint 10.消费Kafka偏移量管理 第六章、StructuredStreaming模块 1....

通过学习Spark,我掌握了分布式数据处理的基本原理和技巧,并通过实践应用到了大规模数据集的处理中。通过学习Spring Boot,我了解了现代化的Java Web开发方式,并通过实践构建了一些简单的Web应用程序。我还意识到...

推荐文章

- GPT-ArcGIS数据处理、空间分析、可视化及多案例综合应用

- 在Debian 10上安装MySQL_debian mysql安装-程序员宅基地

- edge 此项内容已下载并添加到 Chrome 中。_一个小扩展,解决Chrome长期以来的大痛点...-程序员宅基地

- vue js 点击按钮为当前获得焦点的输入框输入值_vue获得当前获得焦点的元素-程序员宅基地

- Android 资源文件中@、@android:type、@*、?、@+含义和区别_@android @*android-程序员宅基地

- python中的正则表达式是干嘛的_Python中正则表达式介绍-程序员宅基地

- GeoGeo多线程_geo 多线程-程序员宅基地

- phpstudy的Apache无法启动_phpstudy apache无-程序员宅基地

- 数据泵导出出现ORA-31617错误-程序员宅基地

- java基础巩固-宇宙第一AiYWM:为了维持生计,两年多实验室项目经验之分层总结和其他后端开发好的习惯~整起_java两年经验项目-程序员宅基地