”数据去重“ 的搜索结果

数据去重方案汇总

数据去重涉及到的面非常广,包括重复数据的发现、去重规则的定义、去重的方法与效率、去重的困难与挑战等等。但是,去重原则只有一个,那就是以业务为导向。根据业务需求去定义重复数据、制定去重规则和方案。在...

RocksDB的调优是个很复杂的话题,详情参见官方提供的tuning guide,以及Flink配置中与RocksDB相关的参数,...在实际处理数据时,如果数据的key(即子订单ID)对应的状态不存在,说明它没有出现过,可以更新状态并输出。

EXCEL,数据筛选/去重

MapReduce操作实例-数据去重.pdf 学习资料 复习资料 教学资源

python中的pandas模块中对重复数据去重步骤: 1)利用DataFrame中的duplicated方法返回一个布尔型的Series,显示各行是否有重复行,没有重复行显示为FALSE,有重复行显示为TRUE; 2)再利用DataFrame中的drop_...

针对Chen等人提出的云存储数据去重方案BL-MLE的计算开销过大的问题,对其方案进行了改进,提出了一种更高效的数据去重方案。首先对BL-MLE方案进行了分析,指出其在计算效率等方面的不足;随后通过使用hash函数和标签...

主要介绍了Django ORM实现按天获取数据去重求和例子,具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧

讲解怎么使用VBA处理 数据,主要是Excel中。包括讲解和源代码,有兴趣的可以看看--------后面描述纯属凑字数,看看即可

MySQL去重复,最近用多线程爬数据的时候有部分数据重复了,现用SQL去重。

海量数据去重 一个文件中有40亿条数据,每条数据是一个32位的数字串,设计算法对其去重,相同的数字串仅保留一个,内存限制1G. 方法一:排序 对所有数字串进行排序,重复的数据传必然相邻,保留第一个,去除后面重复...

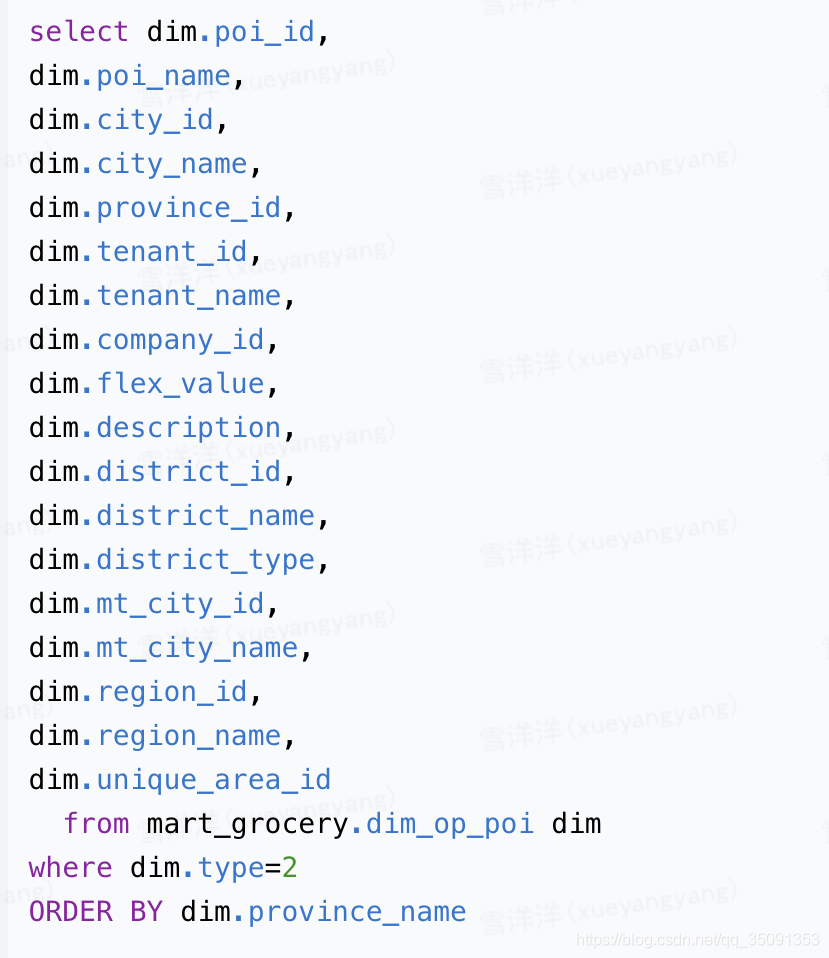

数据库数据去重方法在大量数据库数据处理的时候,发现很多重复项,这些重复项给工作带来很多不便,那么,怎么才能更快的去重呢,有没有好的数据库数据去重方法呢,下面给大家推荐几种数据库数据去重方法,简单的了解...

1.背景介绍 ...在本文中,我们将讨论Flink流处理的一个案例,即实时数据去重。 1. 背景介绍 实时数据流处理是大数据处理领域中的一个重要领域,它涉及到处理和分析大量的实时数据,如日志、传感器...

对数据去重有两种处理方式,如下:1、对重复数据去重,并且会自动排序使用函数 set#列表去重list_a = [6, 6, 5, 1, 2, 2, 3, 4, 4, 4, 6, 7, 8, 8, 8, 10]#仅去重list_aa =set(list_a)print(list_aa)结果如下: ...

3、数据去重,爬虫可以根据不同的场景制定不同的去重方案。1、先学习 Python 包并实现基本的爬虫过程,Python中爬虫的包很多,初学建议可以从requests包和Xpath包开始学习,requests包主要负责连接网站,返回网页,...

数据去重算法程序源代码 让原始数据中出现次数超过一次的数据在输出文件中只出现一次

问题:card 表的 card_number 字段忘记加唯一约束,造成大量数据重复,需要去重。1 测试数据准备创建表123456CREATE TABLE `card` (`card_id` bigint(20) NOT NULL AUTO_INCREMENT COMMENT 'ID',`card_number` ...

Spark 大规模数据去重记数实践

Oracle表中重复数据去重的方法实例详解 我们在项目中肯定会遇到一种情况,就是表中没有主键 有重复数据 或者有主键 但是部分字段有重复数据 而我们需要过滤掉重复数据 下面是一种解决方法 delete from mytest ...

Python数据去重

标签: 数据去重

普通去重: """ 去重并按原文件顺序排序 """ from time import time print('开始去重...') start = time() new_list = [] for line in open(r'e:/Python/mypy/test.txt', 'r+'): new_list.append(line...

本关任务:编写Spark独立应用程序实现数据去重。 相关知识 为了完成本关任务,你需要掌握:RDD的创建;RDD的转换操作;RDD的行动操作。 RDD的创建 使用textFile()方法从本地文件系统中加载数据创建RDD,示例如下: ...

数据去重除了对list循环之外一般会借助Set不包含重复数据特性来达到去重目的。 1、HashSet & LinkedHashSet 重写对象的hashCode和equals,优先判断hashCode返回值是否一样,一样再判断equals。HashSet无序(基于...

推荐文章

- Jetpack Compose中的副作用_disposableeffect-程序员宅基地

- 大数据毕业设计Hadoop+Spark+Hive景区游客满意度预测与优化 旅游推荐系统 Apriori算法 景区客流量预测 旅游大数据 旅游景点推荐 景点规划 计算机毕业设计 机器学习 深度学习-程序员宅基地

- 开发ROS机器人的自动驾驶功能-程序员宅基地

- 《Nature》发布毫米级软体机器人,可在没有任何物理干预情况下游走于人体-程序员宅基地

- Git 生成SSH Key_git publikey生成-程序员宅基地

- itextpdf生成pdf中文乱码 (乱码中挣扎的自述)_acrofields form = stamper.getacrofields();-程序员宅基地

- J.U.C之AQS源码解读以及ReentrantLock源码解读_reentrantlock 源码-程序员宅基地

- 测序总结,高通量测序名词-程序员宅基地

- WinForm界面布局空间---WeifenLuo.WinformUI.Docking-程序员宅基地

- 操作系统作业调度实验报告-程序员宅基地