这段代码首先读取原始 Excel 文件,然后按照 “公司” 列进行分组并将 “数据来源” 列的值合并为列表。接下来,代码遍历每个组...现在需要将这些重复数据去重,并将它们的‘数据来源’合并到一起,作为一条新的记录。

”数据去重“ 的搜索结果

今天小编就为大家分享一篇关于海量数据去重排序bitmap(位图法)在java中实现的两种方法,小编觉得内容挺不错的,现在分享给大家,具有很好的参考价值,需要的朋友一起跟随小编来看看吧

之前有篇文章提到了实现增量爬虫可以利用redis数据库进行url去重,今天博主就给大家分享一下python如何利用redis进行去重吧。在试验中,我们用到Redis数据库和hash算法,我们先了解一下Redis和hashlib。 Redis简介 ...

C#:实现数据去重算法(附完整源码)

在数据开发中,我们不难遇到重复数据的问题,搞过这类数据开发的同志肯定觉得,重复...方案一、根据一定规则分层去重: 海量的数据一般可以根据一定的规则分层,比如:针对海量的小区数据,可以把所在同一区域的小...

C#表格数据去重

c# list数据去重,使用linq的GroupBy数据去重只需要三行代码 模型代码 public class UserInfo { public int id { set; get; } public string name { set; get; } public int typeid { set; get; } } 准备...

最近在一个项目中,需要去除掉重复的数据,之前都是在后台实现,现在客户需求是在前台去重,于是就想到了javascript脚本。

一、对列表去重1.用循环查找的方式li = [1,2,3,3,4,2,3,4,5,6,1]news_li = []for i in li:if i not in news_li:news_li.append(i)print (news_li)2.用集合的特性set()li1 = [1,4,3,3,4,2,3,4,5,6,1]new_li1 = list...

今天小编就为大家分享一篇关于Java List中数据的去重,小编觉得内容挺不错的,现在分享给大家,具有很好的参考价值,需要的朋友一起跟随小编来看看吧

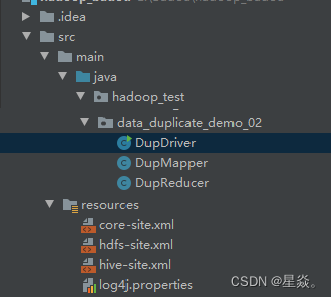

Mapreduce实现数据去重一、数据去重1.1 设计思路1.2 代码实现1.3

针对云存储环境中密钥泄露、数据重复和完整性检验的问题,提出了一种支持密钥更新和密文数据去重的完整性审计方案。所提方案利用布隆过滤器实现了密态数据的客户端去重,且每一次密钥更新能保证更新结果不能由其余...

在Python爬虫中经常使用MongoDB数据库来存储爬虫爬取的结果,于是乎就有了一个问题:百万级的MongoDB数据如何去重? 常见的思路便是在数据入库的时候检查该数据在数据库中是否已经存在,如果存在则忽略(效率高点)...

Hive数据去重举例: Hql代码 INSERT overwrite TABLE store SELECT t.p_key, t.sort_word FROM ( SELECT p_key, sort_word, row_number () over ( distribute BY p_key sort BY sort_word ...

python3数据去重(pandas) 去重操作是我们处理数据的时候经常遇到的! 接下来告诉大家,仅仅用几行代码就可以实现的去重操作 这边会用到pandas库 这是一个非常非常强大的库,这里面有着处理数据特别简单方便的方法...

方法1:delete from xxx(表名) where rowid not in( select max/min(rowid) from xxx(表名) group by xxx(需要去重的列名,可以跟逗号实现多个列名去重))。此方法采用直接删除的方法。但是效率比较低,数据量小的话...

R语言数据列去重1、unique函数2、duplicated函数3、distinct(dplyr包)4 引用 unique对于一个向量管用,对于matrix、data frame那些指定列去重就不管用了 1、unique函数 查看重复的方式,有点像分类变量个数一样...

Java操作xls文件,数据去重 文章目录前言一、读取磁盘文件,进行数据去重处理二、将合并的数据写入到源文件建中总结 前言 根据 表格数据的某一列唯一值生成key,将要进行数据合并列的值作value进行value值得去重...

第一种 ON DUPLICATE KEY UPDATE INSERT INTO test_unique(uid,username,upassword) VALUES (NULL,‘1006’,‘135’) ON DUPLICATE KEY UPDATE username=VALUES(username); on duplicate 更新对主键索引没有影响....

1、聚合中去重(聚合函数中添加参数distinct=True) goods_pay_rank = Pay.objects.filter( pay_time__range=[start_time, end_time]).values( 'order__order_details__goods_attribute__goods').annotate( ...

mysql数据去重的三种方式

目标是在第一列中查找并记录不重复的值,并将它们存储在第二列中。这样,第二列将包含第一列中的唯一值,按升序排序。

数据去重 "数据去重"主要是为了掌握和利用并行化思想来对数据进行有意义的筛选。统计大数据集上的数据种类个数、从网站日志中计算访问地等这些看似庞杂的任务都会涉及数据去重。下面就进入这个实例的MapReduce程序...

推荐文章

- Android 编译so文件 MP4V2_android下编译mp4v2-程序员宅基地

- 通讯录Contact_02_contact文件内容-程序员宅基地

- Qt笔记(四十二)之QZXing的编译 配置 使用_qzxingfilterrunnable error:-程序员宅基地

- 关于画图软件Dia打开程序始终为英文界面的问题-程序员宅基地

- OpenCV从入门到精通实战(二)——文档OCR识别(tesseract)-程序员宅基地

- 详解avcodec_receive_packet 11_avcodec_receive_packet eagain-程序员宅基地

- OpenGL SuperBible 7th源码编译记录_superbible7-media github-程序员宅基地

- Wireshark简单使用-程序员宅基地

- MXNet 粗糙的使用指南_iou loss mxnet-程序员宅基地

- iOS对ipa包进行代码混淆《二》 ---代码混淆_ipa包混淆-程序员宅基地