”模型量化“ 的搜索结果

模型量化--超详细解惑

标签: 人工智能

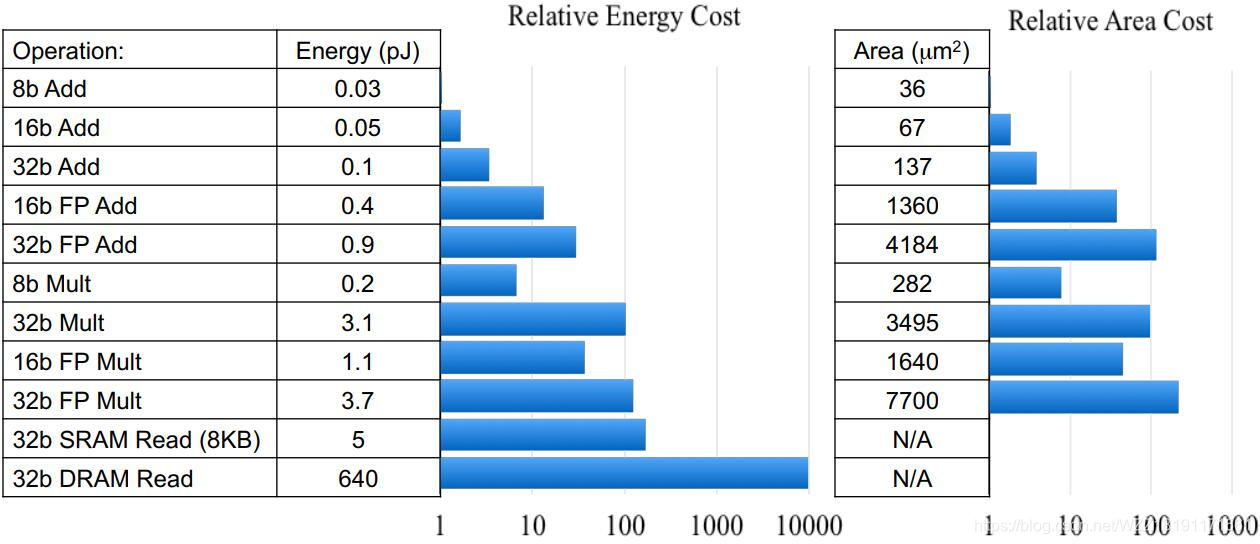

量化就是把高位宽(Float32)表示的权值或者激活值用较低位宽来近似表示(INT8, INT4,……),在数值上的体现就是将连续的值离散化。即原来表示一个权重需要使用float32表示,量化后只需要使用int8位。

Pytorch 模型量化

标签: 模型量化

Pytorch 模型量化.姿态估计使用 Pytorch 进行模型的静态量化、保存和加载.运行pth_to_int.py以获取量化模型。运行evaluate_model.py进行推理。模型尺寸从200M减小到50M。推理时间缩短约 20%。

在深度学习中,量化指的是使用更少的bit来存储原本以浮点数存储的tensor,以及使用更少的...一个量化后的模型,其部分或者全部的tensor操作会使用int类型来计算,而不是使用量化之前的float类型。当然,量化还需要底...

本文介绍模型量化

模型量化(Model Quantization)通过某种方法。比如说原来的模型里面的权重(weight)都是float32,通过模型量化,将模型变成权重(weight)都是int8的定点模型IEEE标准中的FP16格式如下:取值范围是5.96× 10−8 ~ ...

基于pytorch的模型剪枝+模型量化+BN合并+TRT部署(cifar数据)

这些年来,深度学习在众多领域亮眼的表现使其成为了如今机器学习的主流方向,但其巨大的计算量仍为人诟病。...而模型量化属于非常实用的模型压缩技术,并且当前已经在工业界发展非常成熟。模型量化所处位置。

深度学习模型的量化操作

量化投资策略源码模型量化策略代码量化选股 量化择时量化资产配置财务指标选股研究系列成长股选股模型多因子选股模型事件驱动策略系列选股因子研究系列分析师荐股能力评定与跟踪利用分析师盈利预测数据挖掘投资机会...

模型量化是一种将浮点计算转成低比特定点计算的技术,可以有效的降低模型计算强度、参数大小和内存消耗,但往往带来巨大的精度损失。尤其是在极低比特(<4bit)、二值网络(1bit)、甚至将梯度进行量化时,带来的精度...

基于使用RFM+R模型量化用户价值进行金融产品精准营销.zip基于使用RFM+R模型量化用户价值进行金融产品精准营销.zip基于使用RFM+R模型量化用户价值进行金融产品精准营销.zip基于使用RFM+R模型量化用户价值进行金融产品...

可以根据实际业务需求将原模型量化成不同比特数的模型,一般深度神经网络的模型用单精度浮点数表示,如果能用有符号整数来近似原模型的参数,那么被量化的权重参数存储大小就可以降到原先的四分之一,用来量化的比特...

很棒的模型量化 这个 repo 收集了关于模型量化的论文、文档和代码,供任何想要对其进行研究的人使用。 我们正在不断改进该项目。 欢迎 PR 被 repo 遗漏的作品(论文、存储库)。 目录 调查_论文 Survey_of_二值化 ...

本工程包含两部分,分别是:模型 训练源代码 和 模型量化 源代码,前者基于pytorch平台,后者分别基于RK和Ascend(coming soon)平台。 Train-模型训练&推理源码 该文件夹是相关基础人工智能模型的训练推理源代码,...

在今日这个由数据驱动的时代,人工智能技术的快速发展正不断拓展着社会和技术的边界。随着大语言模型应用的深入人心,我们对大语言模型的部署和效率提出了更高的要求。

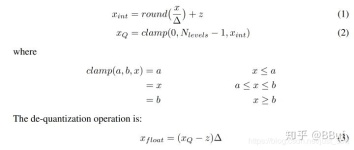

在量化方法中,**非对称量化**和**对称量化**是两种常见的量化策略,它们各有特点和应用场景。白话说就是**对称量化时0点对齐**。

由于在RKNN模型构建的过程中,对模型进行了量化,会无可避免的造成精度损失,使用精度分析接口,可以查看每一层的精度损失情况。通过混合量化,将某些损失较大的层,从量化层转为非量化层,从而提高模型的精度。

训练后量化(Post-training Quantization,PTQ)是一种常见的模型量化技术,它在模型训练完成之后应用,旨在减少模型的大小和提高推理速度,同时尽量保持模型的性能。训练后量化对于部署到资源受限的设备上,如移动...

AWQ模型量化实践

量化相关技术

针对深度学习算法模型参数大,部署后会占用内存、计算量增加及...难训练,可以从另外一个角度出发,对模型进行量化:其主要是通过减少原始模型参数的数量或比特数来实现对内存和计算需求的降低,从而进一步降低能耗。

pytorch 量化 wenet

模型量化是指将神经网络的浮点算法转换为定点。量化有一些相似的术语,低精度(Lowprecision)可能是常见的。低精度模型表示模型权重数值格式为FP16(半精度浮点)或者INT8(8位的定点整数),但是目前低精度往往就...

总的来看,模型量化的精度损失取决于多种因素,包括所使用的量化策略、模型的特性,以及实际应用中的需求等。现在,我们把这个0到1之间的范围称为一个权重,看成一片连续的水面,上面表中的值看成一个一个的“落脚点...

推荐文章

- 手写一个SpringMVC框架(有助于理解springMVC) 侵立删_springmvc可以用来写安卓后端吗-程序员宅基地

- 线性判别分析LDA((公式推导+举例应用))_lda推导-程序员宅基地

- C# 结构体(Struct)精讲_c# struct-程序员宅基地

- 支付宝Wap支付你了解多少?_阿里wap支付-程序员宅基地

- Java计算器编写,实现循环输入_java简易计算器可使用户多次输入-程序员宅基地

- 【多维Dij+DP】牛客小白月赛75 D-程序员宅基地

- Android之内存优化与OOM-程序员宅基地

- Azure Machine Learning - 视频AI技术_azure ai 視頻索引器-程序员宅基地

- 个人知识管理软件使用感受-程序员宅基地

- WWDC2019 ------深入理解App启动_wwdc app启动-程序员宅基地