”集成学习“ 的搜索结果

集成学习

标签: 决策树 学习 集成 集成学习

1.集成学习简介 一个牛逼的算法和10个简单的算法比,后者更好一点。 所以在解决过拟合和欠拟合问题的时候,使用boosting 和bagging 的方法。 欠拟合问题解决:弱弱组合变强 boosting 过拟合问题解决:相互牵制变壮 ...

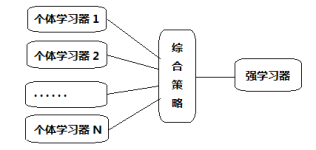

Ensemblelearning中文名叫做集成学习,它并不是一个单独的机器学习算法,而是将很多的机器学习算法结合在一起,我们把组成集成学习的算法叫做“个体学习器”。在集成学习器当中,个体学习器都相同,那么这些个体学习...

Ensemble Learning Toolbox

在机器学习的广袤领域中,集成学习是一种强大且灵活的策略,它通过将多个单独的学习器(或称为“基学习器”)组合起来,形成一个更加强大的学习器,以提升模型的预测性能。集成学习的核心思想在于“集体智慧”的力量...

它的思路和Stacking几乎是完全一样的,唯一的不同之就是Blending 的过程中不进行K折验证,而是只将原始样本训练集分为训练集和验证集,然后只针对验证集进行预测,生成的新训练集就只是对于验证集的预测结果,而不是...

本文主要简单介绍了集成学习的基本概念,优缺点,应用场景,实现方法,以及bagging, boosting, 堆叠法三种集成学习的建模过程,示例和模型参数等。

一. 集成学习的概念与主要类型 1.1 集成学习的概念与意义 1.2 主要类型与差别 二. 简单的集成方法 三. Boosting 四. Bagging 五. Stacking 六. Random Forest 七. GBDT

详细讲解了集成学习的主要方法:Voting、Bagging、Boosting和Stacking。每一种集成方法都配有详细的代码讲解。能够使用集成模型完成分类或回归任务。

集成学习(Ensemble Learning)有时也被笼统地称作提升(Boosting)方法,广泛用于分类和回归任务。它最初的思想很简单:使用一些(不同的)方法改变原始训练样本的分布,从而构建多个不同的分类器,并将这些分类器...

集成学习是一种强大的机器学习方法,它通过构建并结合多个学习器(也称为“基学习器”或“弱学习器”)的预测结果来完成学习任务。集成学习的主要目的是通过结合多个学习器的预测结果来提高模型的泛化能力和鲁棒性,...

人工智能-项目实践-集成学习-串行集成学习方法 自适应增强 Adaboost

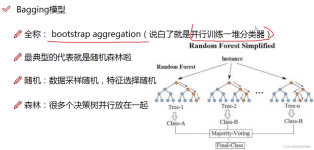

Bagging基本流程:通过上述自助采样,采出T个含m个训练样本的采样集,然后基于每个采样集训练出一个基学习器,在将这些基学习器进行组合。在对预测输出进行结合的时候,Bagging通常对分类任务使用简单投票法,对回归...

集成学习训练模型用的数据集成学习训练模型用的数据集成学习训练模型用的数据

集成学习作为一种多模型融合的思想,在机器学习领域具有广泛的应用前景。通过结合多个基学习器的预测结果,集成学习可以有效地提高模型的预测精度和稳定性,降低过拟合和欠拟合的风险。未来,随着数据量的不断增长和...

假设我们有三个样本,h1、h2、h3代表三个分类器,预测结果如下:对于上图这种结果,我们可以看到h1、h2、h3预测的准确率都是2/3,我们让h1、h2、h3进行投票,发现在最后一行,三个样本都预测对了,这样便是产生了...

参考:ysu老师课件+西瓜书 +期末复习笔记。

机器学习课程PPT-集成学习-学生课件

基于改进卷积神经网络与集成学习的人脸识别算法.pdf

在每轮训练期间,都会向集成中添加一个新的弱学习器,并调整权重向量以重点关注前几轮中错误分类的示例。如此重复进行,直至基学习器数目达到事先指定的值T,最终将这T个基学习器进行加权结合。弱学习器的关键特征是...

并且可以使用交叉验证等技术来选择最优的模型,根据性能评估的结果,可以调整集成学习器的参数,如基学习器的数量、投票策略等,以优化其性能。集成学习是机器学习中的一种思想,它通过多个模型的组合形成一个精度更...

同济大学机器学习课程PPT

本篇博文将重点讲解两个可以显著提升机器学习模型性能的高级策略:集成学习和超参数优化。在本篇博文中,我们探讨了如何通过集成学习和超参数优化提升模型的性能。Bagging和Boosting是两种强大的集成学习方法,而...

其中,随机森林作为一种集成学习方法,以其高效性、准确性和易用性而受到广泛关注。Python作为数据科学的首选编程语言,提供了丰富的库和工具来实现随机森林算法。本文将围绕Python数据的随机森林集成学习方法进行...

集成学习基础思维导图,根据该导图可以对集成学习有一个框架上的了解,学习了解bagging、boosting、下的随机森林、GBDT、xbg等

集成学习是使用一系列学习器进行学习,并使用某种规则把各个学习结果进行整合从而获得比单个学习器更好的学习效果的一种机器学习方法。集成学习可以提升机器学习算法。本视频教学课程主要讲解:个体与集成、Boosting...

集成学习pdf讲义超详细

标签: 集成学习

集成学习pdf讲义超详细

集成学习(Ensemble Learning),通过构建并结合多个学习器来完成学习任务。一般结构是:先产生一组“个体学习器”,再用某种策略将它们结合起来。结合策略主要有平均法、投票法和学习法等。因此,有时也称集成学习...

推荐文章

- Android RIL框架分析-程序员宅基地

- Python编程基础:第六节 math包的基础使用Math Functions_ps math function-程序员宅基地

- canal异常 Could not find first log file name in binary log index file_canal could not find first log file name in binary-程序员宅基地

- 【练习】生成10个1到20之间的不重复的随机数并降序输出-程序员宅基地

- linux系统扩展名大全,Linux系统文件扩展名学习-程序员宅基地

- WPF TabControl 滚动选项卡_wpf 使用tabcontrol如何给切换的页面增加滚动条-程序员宅基地

- Apache Jmeter常用插件下载及安装及软硬件性能指标_jmeter插件下载-程序员宅基地

- SpringBoot 2.X整合Mybatis_springboot2.1.5整合mybatis不需要配置mapper-locations-程序员宅基地

- ios刷android8.0,颤抖吧 iOS, Android 8.0正式发布!-程序员宅基地

- 【halcon】C# halcon 内存暴增_halcon 读二维码占内存-程序员宅基地